DeepSeek安装使用教程

DeepSeek R1 越狱版安装教程

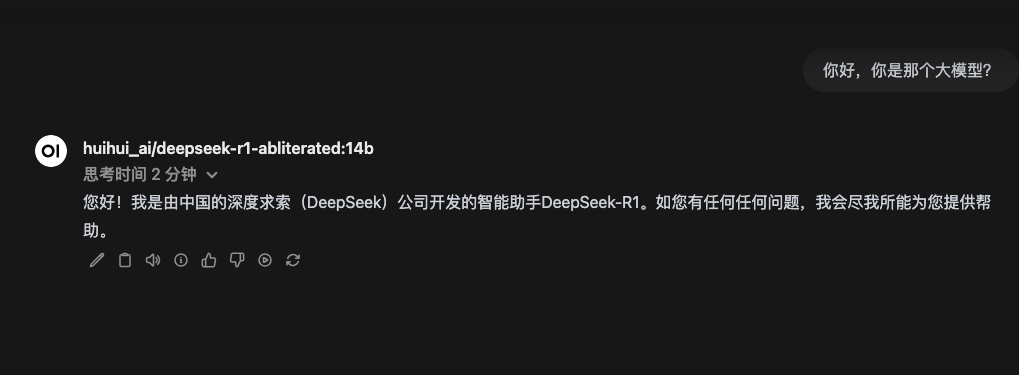

DeepSeek R1 越狱版现已在 Hugging Face 上线,支持 8B、14B、32B 等多个版本。本文将详细介绍如何在本地部署和使用 DeepSeek R1 越狱版。

模型说明

虽然官方版 DeepSeek 是 671B 参数量的大模型,但普通用户难以本地运行。目前可供本地部署的是经过蒸馏压缩的 7B-70B 等小型版本,已足够日常使用。

DeepSeek 是一个强大的代码助手,它具有以下特点:

- 支持多种编程语言

- 代码补全和生成能力强

- 可以解释代码、回答编程问题

- 支持中英双语交互

安装环境

- 系统: windows 10/macOS 11 及以上

- 处理器(CPU):Intel Core i5 或更高;

- 内存(RAM):16GB 或更高;

- 显卡(GPU):NVIDIA GeForce RTX 3060 或 AMD Radeon RX 6700 XT,8GB 显存;

- 硬盘空间:建议使用 SSD,预留 30GB 以上

安装步骤

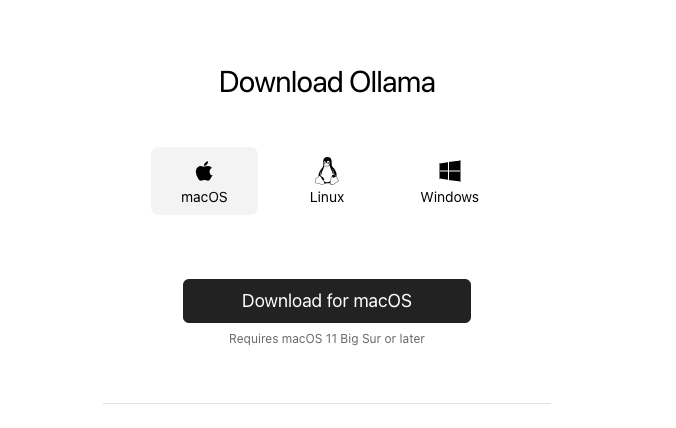

1. 安装 Ollama

首先需要下载并安装 Ollama,这是运行模型的基础环境。访问 Ollama 官网 下载对应系统版本。

2. 下载模型

打开命令行终端,根据需要运行以下命令之一来下载对应版本的模型(需科学上网才能下载):

7B 版本(推荐显存 8G):

1 | |

8B 版本(推荐显存 8G):

1 | |

14B 版本(推荐显存 12G):

1 | |

32B 版本(推荐显存 32G):

1 | |

70B 版本(需要高端显卡支持):

1 | |

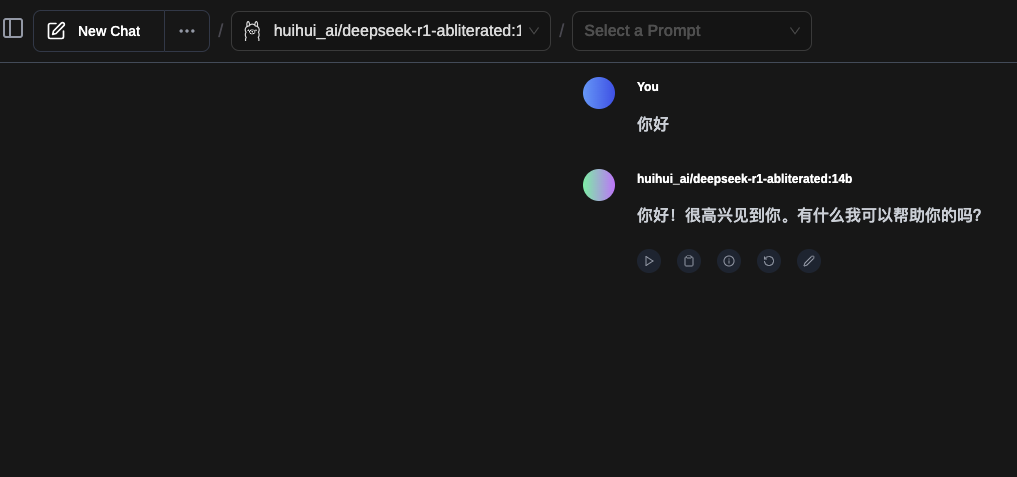

3. 安装 Web UI

方式一:Chrome 插件

下载地址:Chrome 插件

特点:需要 chrome 浏览器并科学上网才能安装,但是安装后可以随时随地使用,不需要安装其他软件或复杂的配置。

方式二:OpenWebUI

需要安装 docker 并科学上网,安装后可以随时随地使用,不需要安装其他软件或复杂的配置。但需要一定的编程基础。

1 | |

安装完成后访问 http://localhost:3002 即可使用。

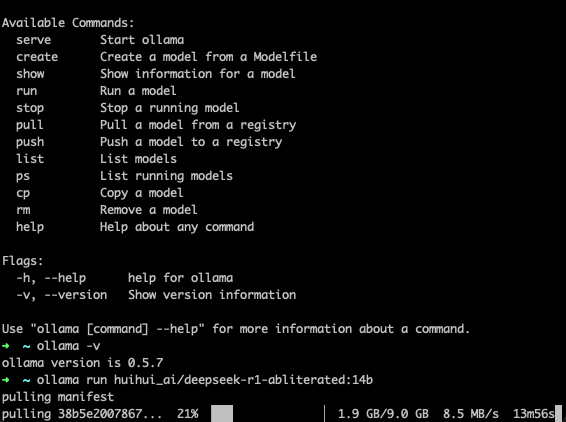

Ollama 常用命令

在使用 Ollama 时,以下是一些常用的命令操作:

1 | |

这些命令可以帮助你更好地管理和使用 Ollama 平台上的模型。

使用技巧

代码生成

- 描述需求要清晰具体

- 指定编程语言和框架版本

- 说明性能和兼容性要求

代码解释

- 可以询问特定代码段的功能

- 请教最佳实践和优化建议

- 寻求 debug 帮助

项目开发

- 协助设计系统架构

- 生成项目脚手架

- 编写单元测试

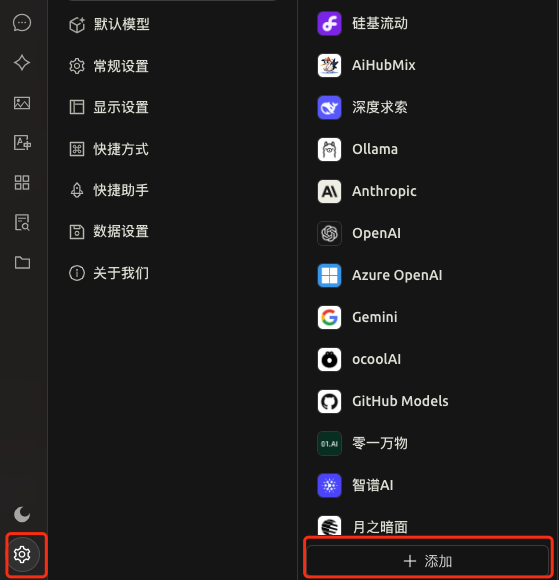

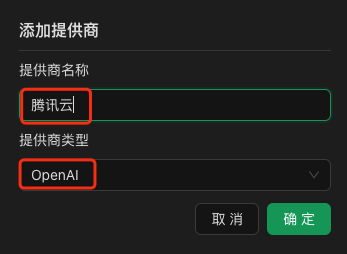

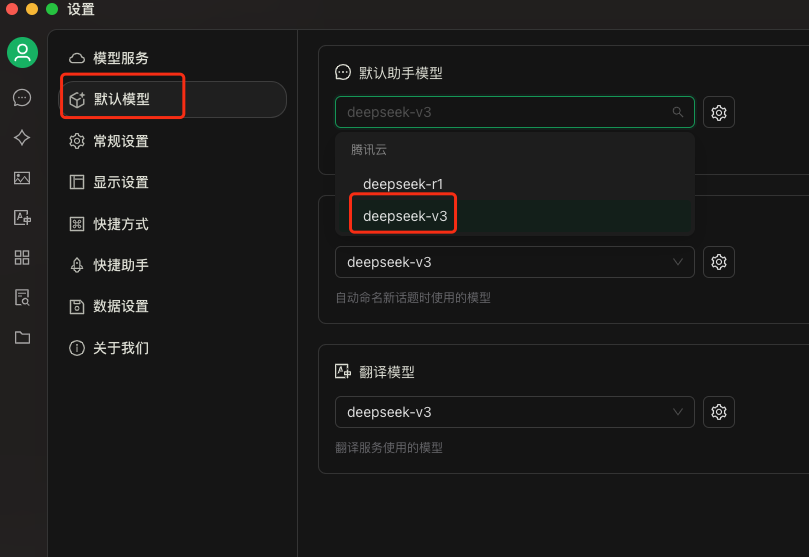

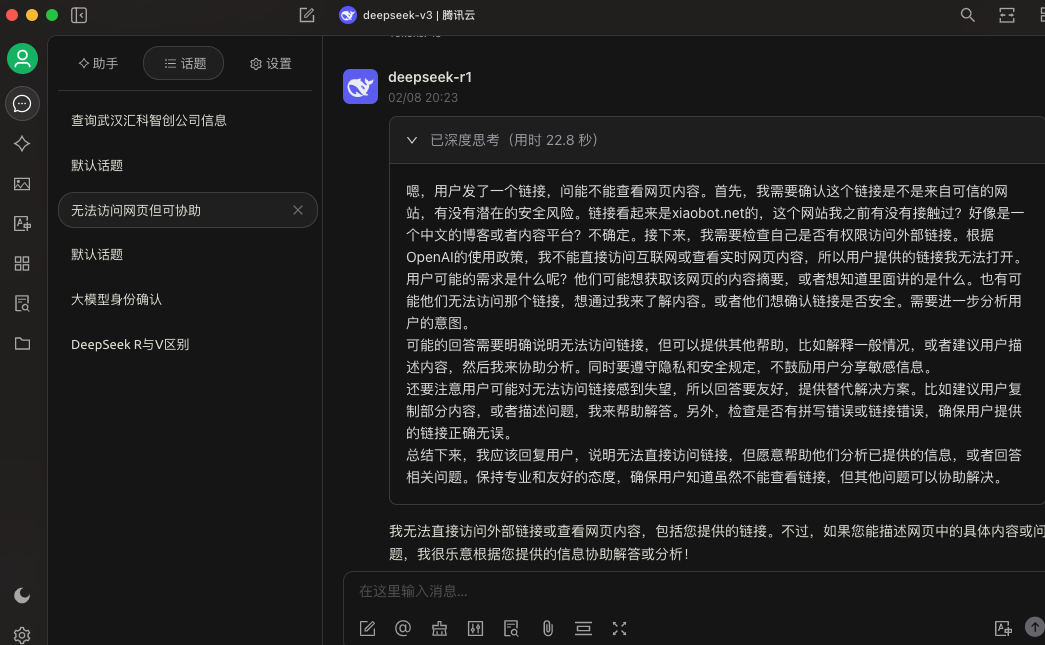

使用 Cherry Studio 免费体验

除了本地部署外,你还可以通过 Cherry Studio 免费体验腾讯部署的 DeepSeek 模型。

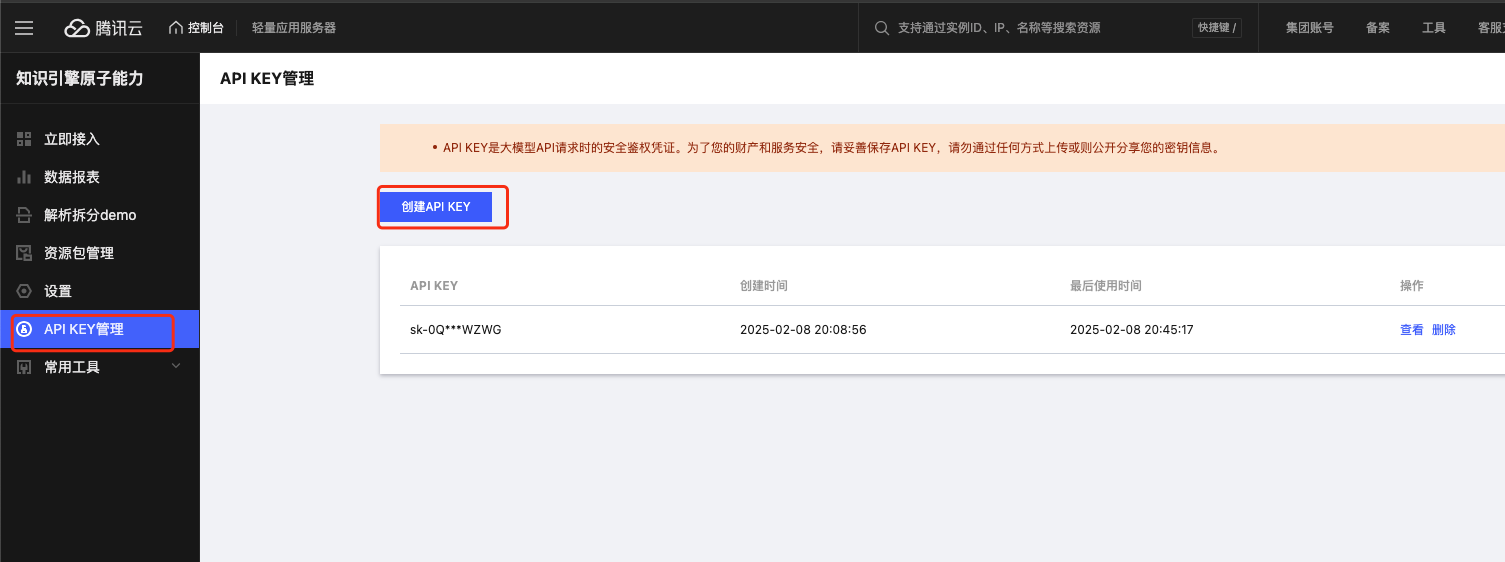

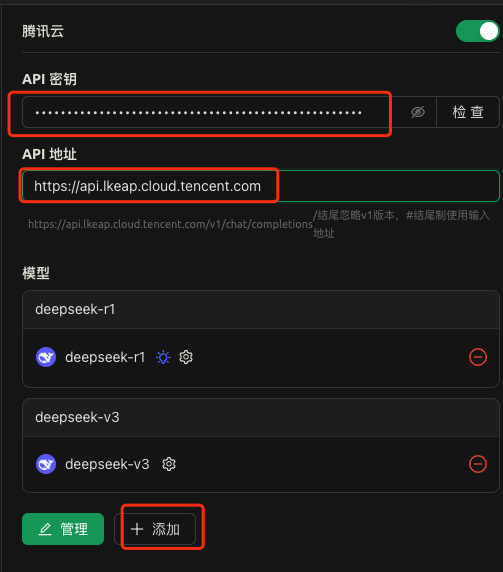

访问方式

-

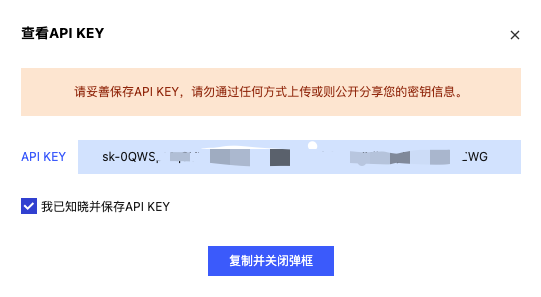

登录腾讯云账号,创建 API 密钥

- 访问 腾讯云 API 密钥申请地址 申请 API 密钥

- API 地址:https://api.lkeap.cloud.tencent.com

在模型列表中选择 DeepSeek-R1 或 DeepSeek-V3

优势

- 无需本地部署,直接使用

- 免费额度充足

- 腾讯云服务器支持,响应速度快

- 支持多种模型版本切换

- 内置代码编辑器

使用限制

- 每日免费额度有限

- 需要网络连接

- 部分高级功能需要付费

- API 调用次数有限制

使用建议

- 可以先用 Cherry Studio 测试效果

- 确认适合再考虑本地部署

- 个人开发推荐使用免费版

- 企业用户建议付费解锁完整功能

注意事项

- 选择合适的模型版本要根据自己的硬件配置

- 首次下载模型可能需要较长时间

- 建议使用稳定的网络连接

- 使用代理网络可能会加快下载速度

- 定期更新模型以获得更好的性能

上网工具推荐

推荐:低至 7 元/100G/月机场

推 200 元一年腾讯海外服务器

相关视频

如果文章对你有帮助,欢迎点击上方按钮打赏作者,更多功能请访问博客站

支付宝打赏

支付宝打赏  微信打赏

微信打赏